KI-gestütztes Wissensmanagement: RAG als Brücke zum Unternehmenserfolg

KI-Technologie ist gleichermaßen Chance und Herausforderung. Viele Unternehmen fragen sich derzeit zurecht, wie sie KI-Systeme zielgerichtet und nachhaltig für ihren Geschäftserfolg einsetzen können. Viele halten die Hürden für nahezu unüberwindlich, eine individuell angepasste KI zu erschaffen.

Dabei sind die Anwendungsfälle naheliegend und die Möglichkeiten verlockend. Beim internen Wissensmanagement oder im Vertrieb zum Beispiel können etwa sogenannte Large Language Models (LLM) durchaus unterstützen. Dazu wird aber das „mitgebrachte“ Wissen der KI-Modelle nicht ausreichen. Man muss diese mit Wissen aus dem eigenen Unternehmen anreichern.

Möglich wird das durch Retrieval-Augmented Generation, kurz RAG. Mithilfe dieser Vorgehensweise können Unternehmen ihr bestehendes Wissen aufbereiten und einer KI zur Verfügung stellen – im Sinne einer Optimierung ganz ohne zeit- und ressourcenaufwändiges Training.

Wofür benötigt man RAG?

Beim „Training“ einer KI, insbesondere eines LLM, werden große Mengen von Textdaten, Mustern, Spracheigenschaften und Zusammenhängen verarbeitet, um später auf Basis dieser Daten menschenähnliche Texte zu erzeugen oder Fragen zu beantworten. Für ein eigenes KI-Systemen müssten diese Daten gesammelt, aufbereitet und mithilfe von hoher Rechenleistung in die KI überführt werden. Für viele Unternehmen ist dieses Vorgehen schlichtweg nicht wirtschaftlich. RAG schafft hier Abhilfe und vereinfacht das Hinzufügen von eigenen Wissensquellen erheblich – zugunsten sehr guter Ergebnisse und wesentlich geringerer Kosten.

Mögliche Anwendungsfälle für das Softwaresystem

Mithilfe von RAG lassen sich auch große Mengen an Daten mit hoher Geschwindigkeit für eine KI zur Verfügung stellen. Das ist überall dort nützlich, wo aktuelle, spezifische Informationen gefragt sind. So kann beispielsweise ein Chatbot im Kundenservice Fragen anhand von mehreren Tausend Datenblättern beantworten. Oder ein Onboarding-Chatbot erklärt neuen Mitarbeitenden, wo sie bestimmte Informationen finden können.

Kurzum: Durch RAG tragen interne Daten und Dokumente erheblich zur Qualität KI-generierter Ergebnisse bei.

Wie funktioniert RAG?

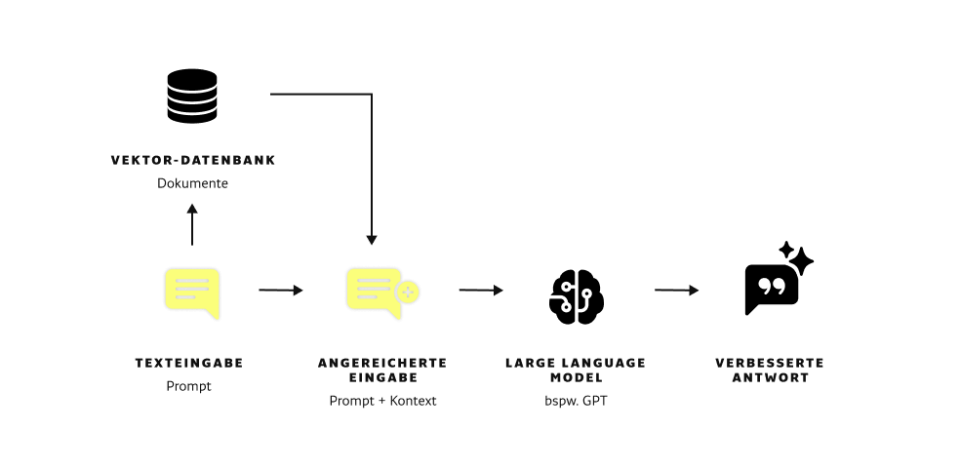

RAG ist eine Methode, die für jede Anfrage eines Benutzers erweiterte Antworten liefert – vergleichbar mit einer Eingabe in ChatGPT, jedoch angereichert mit Kontext aus firmeninternen Quellen. Dieser Kontext besteht aus Dokumenten, Webseiten oder anderen textbasierten Daten des Unternehmens.

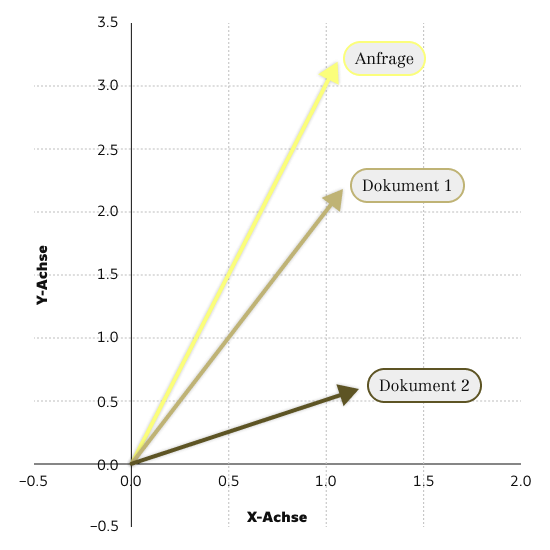

Im Detail sieht die Funktionsweise so aus: Auf die Anfrage des Nutzenden hin sucht die Anwendung in einer Datenbank nach passenden Dokumenten. Hierbei wird der Anfragetext zunächst in einen sogenannten Vektor umgewandelt. Vektoren sind eine mathematische Repräsentation davon, was in einem Text steht. Dazu kommt ein KI-Modell zum Einsatz, das die Bedeutung der Anfrage erfasst und daraus einen Vektor erstellt. Je größer der Vektor ist, desto genauer werden kleine Unterschiede zwischen Texten erfasst. Allerdings benötigen größere Vektoren mehr Speicher und mehr Rechenleistung.

Das System vergleicht dann den Vektor der Anfrage mit den gespeicherten Dokumentvektoren, um die ähnlichsten zu finden. Dafür wird oft die Cosinus-Ähnlichkeit verwendet, eine mathematische Methode zur Bestimmung der Ähnlichkeit zwischen Vektoren. Je größer die Ähnlichkeit zwischen dem Anfragevektor und einem Dokumentvektor ist, desto höher ist die Wahrscheinlichkeit, dass das entsprechende Dokument die relevante Antwort enthält.

Dieser Prozess ermöglicht es, aus einer großen Menge von Informationen effizient die relevantesten für eine bestimmte Anfrage zu identifizieren.

RAG hat enorme Vorteile...

RAG verbessert die Wissensbasis von KI-Systemen eindrucksvoll. Für den Einsatz des Systems spricht vieles:

- Kein Training notwendig: Neues Wissen muss nicht mithilfe von Training in das Modell übertragen werden.

- Kleinere Modelle performen besser: Durch das Ergänzen von Wissen erzielen Modelle mit einer geringeren Parameterzahl (Größe) eine deutlich bessere Genauigkeit

- Halluzinationen werden reduziert: Nur selten kommt es zu glaubwürdigen Antworten auf Basis falscher Informationen.

- Flexibilität: Ein RAG-Setup kann jederzeit mit neuen Daten ergänzt werden, die der KI rasch zur Verfügung stehen.

...aber auch Grenzen

Keine Technologie ist perfekt, und auch wenn RAG ein hervorragendes Werkzeug ist, ist einiges zu beachten:

- Halluzinationen lassen sich nicht zu 100 % ausschließen.

- Es ist nicht immer leicht, das passende LLM für einen bestimmten Anwendungsfall zu wählen. Wenn man lange und komplexe Quellen als Kontext übergibt, muss das LLM Details und Zusammenhänge erfassen und deuten können. Kleinere Modelle wirken zwar kostengünstig, doch größere Modelle eignen sich oft besser für komplexe Quellen. Dabei sollte man die höheren Kosten für Hardware und Betrieb im Auge behalten.

- Vorhandene Daten müssen zunächst gesammelt, geordnet und dem KI-Modell verfügbar gemacht werden, was vorab Ressourcen erfordert.

Schlechter Kontext ist wie kein Kontext

Generell eignen sich alle textbasierten Dateien wie PDF-Dateien, Word-Dokumente, Excel-Tabellen sowie Website-Inhalte als Dokumentenbasis für eine KI-Anwendung, wie zum Beispiel einen Chatbot. Allerdings gilt es zu beachten, dass die Qualität der Daten maßgeblich ist für die Qualität der Ergebnisse. Grundsätzlich ist es vorteilhaft, wenn man die Dateien, die als Kontext dienen sollen, um möglichst viele unnötige Inhalte bereinigt, um die Informationsdichte zu erhöhen. Das kann die Ergebnisse des RAG-Setups stark verbessern und eine „Kontext-Überforderung“ vermeiden.

RAG On-Premises: Ihre Daten bleiben sicher

Eine berechtigte Sorge beim Einsatz von KI-Lösungen ist und bleibt der Datenschutz. Wie kann ein Unternehmen sicherstellen, dass seine Daten bei einem Cloud-KI-Anbieter sicher sind? KI-Modelle auf Basis von Open Source erlauben es uns, KI-RAG-Lösungen auf unternehmenseigener Hardware „hinter der Firewall“ zu betreiben. Dadurch entfällt eine Datenübertragung in die USA. Unternehmensdaten verlassen nicht die EU, und wenn gewünscht, nicht einmal das eigene Rechenzentrum.

RAG-Lösungen von UEBERBIT und Partnern

UEBERBIT entwickelt und testet kontinuierlich verschiedene Anwendungen auf Basis von KI und RAG. Wir erforschen die ständig neuen Möglichkeiten, die sich durch KI eröffnen, um unserer Kundschaft die besten Lösungen für ihre Wertschöpfung zu bieten.

Dabei setzen wir neben der Eigenentwicklung von komplett maßgeschneiderten KI-Lösungen auch auf Unterstützung von CommaSoft. Mit CommaSoft haben wir einen starken Partner gewählt, der Open-Source-Modelle wie LLaMA von Meta speziell für den deutschen Markt trainiert. Und auch durch die SaaS-App Alan, die eine simple Oberfläche für das Pflegen von RAG-Dokumenten aufweist, legt das Unternehmen den Grundstein für das Rapid Development von RAG-basierten KI-Lösungen.

Wenn Sie erfahren möchten, wie Sie RAG in Ihrem Unternehmen einsetzen können, oder auch andere Möglichkeiten der Individualisierung von KIs wie Chunking oder Reranking, Modelfiles und Systemprompting kennenlernen möchten, sprechen Sie uns an.

Über den Autor

Lukas Köhler

AI Engineer (DHBW)

Lukas studiert das Fach Onlinemedien. Im Rahmen seines dualen Studiums entwickelt er bei UEBERBIT effiziente KI-Lösungen für Unternehmen.

Bilder: Grafiken und Portrait-Aufnahmen von UEBERBIT, Foto von Pexels/Google DeepMind